Appearance

AI技术分享会

AIGC的应用

AIGC(AIGC是Artificial Intelligence Generated Content,即AI生成内容的简写)

春节期间,Deepseek爆火,大家都想尝试一下,导致Deepseek的官网,尤其是深度思考R1模型,一度崩溃。

AIGC的应用:

- 文本生成(包括代码生成)

- 图片生成

- 视频生成

- 音频生成

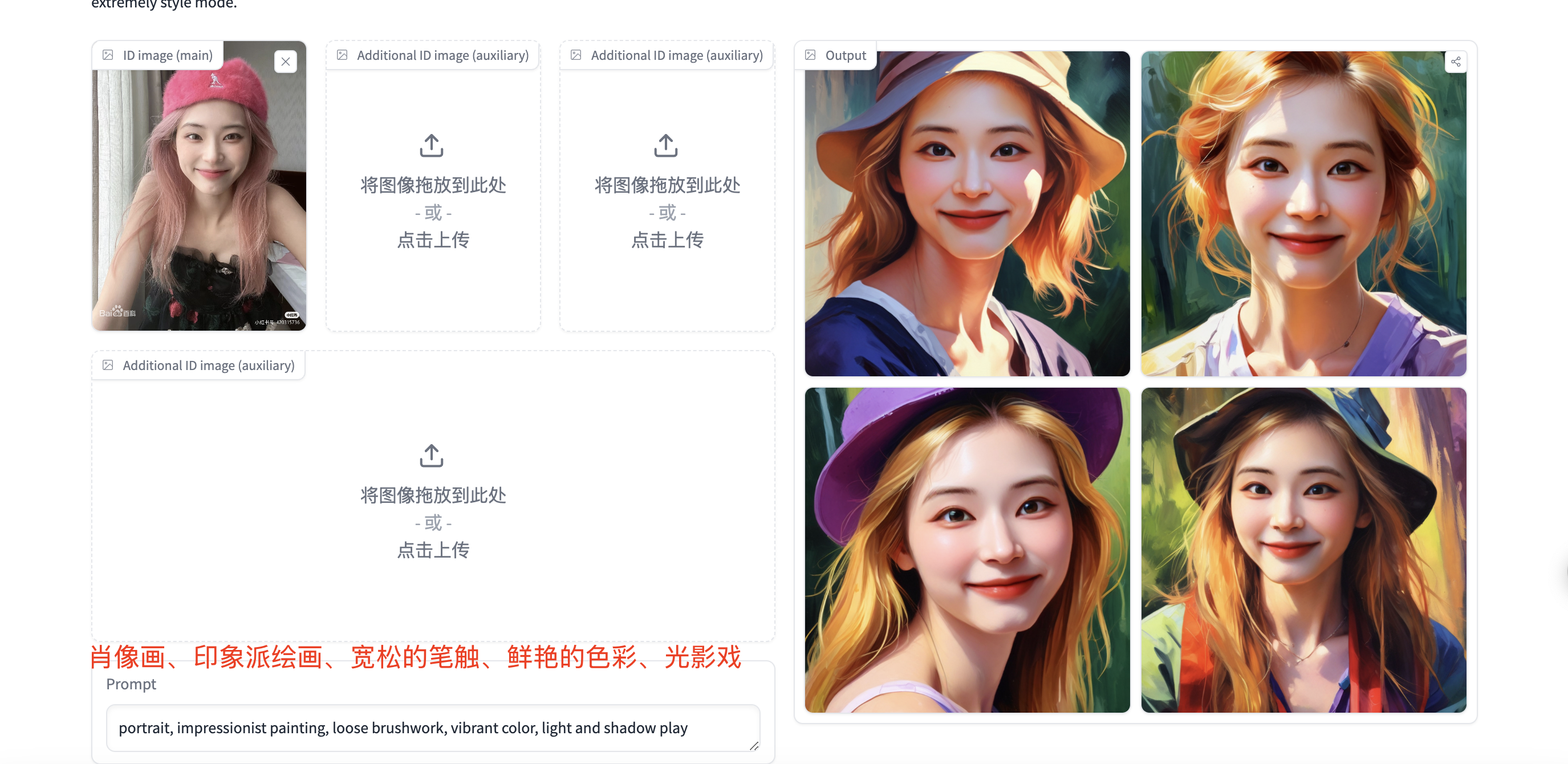

先轻松一下,介绍一个好玩的AIGC应用。

PuLid生成数字分身

AI大模型基础知识

大模型的分类

大语言模型

LLM(Large Language Model)

专门用于处理自然语言处理任务,能够处理文本输入,用于文本生成、文本补全。如GPT-3.5,Deepseek R1等。最近Deepseek R1推理模型爆火。

传统大语言模型,更注重文本生成能力,能够根据输入生成连贯的文本,但在逻辑推理和问题解决方面表现有限。 而Deepseek R1,OpenAI O1等推理模型基于思维链(CoT),CoT的核心原理是 “分而治之” 策略,当面对复杂难题时,模型摒弃直接生成答案的简单做法,而是有条不紊地通过一系列中间步骤进行逻辑推导。多模态大模型

LMM(Large Multimodal Model)

能够处理多种不同类型的数据输入,包括文本、图像、音频和视频,如GPT-4o,GLM-4v。

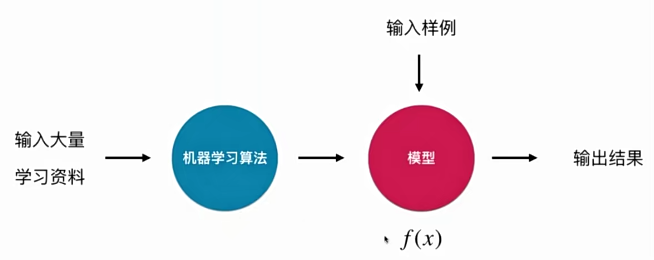

大模型原理

我们可以把大模型理解成函数 y = f(x),x是输入,y是输出。f(x)就是机器学习算法在学习大量学习资料的基础上训练出的模型,根据得到的模型f(x),我们可以根据输入x得到输出结果值y。

例如 y = ax+b,a和b就是模型参数,x是输入,y是输出。机器学习的目的就是根据大量的训练数据(学习资料)找出合适的模型参数。

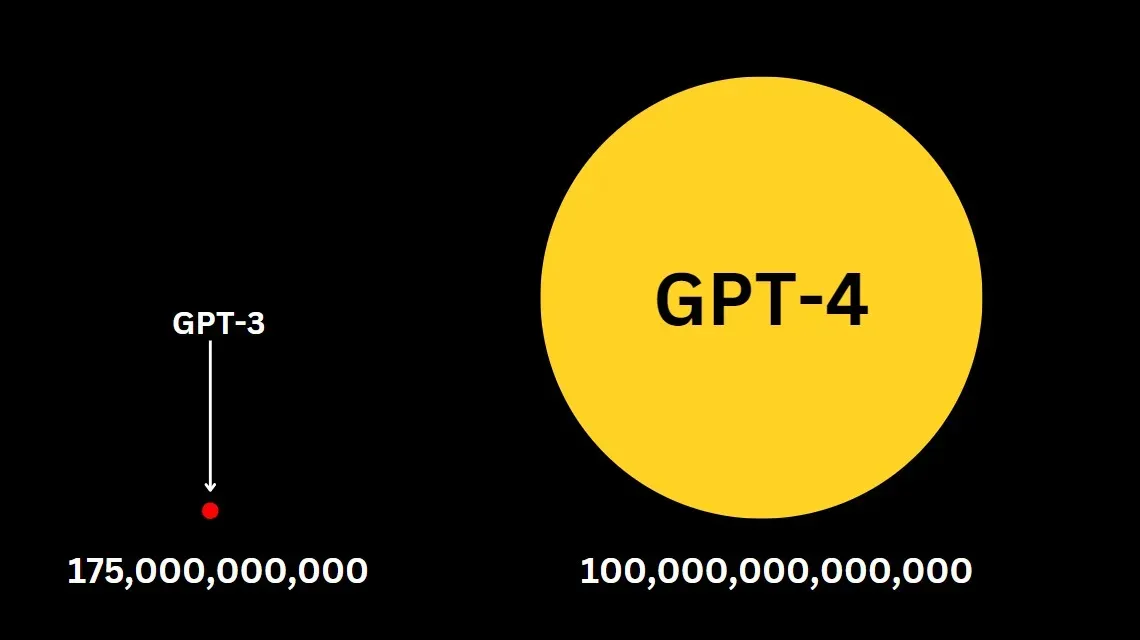

当然这只是简单举例,真正的大模型参数可不止a和b两个。y = a1x1 + a2x2 + .... + anxn + b。GPT-3.5有1750亿个参数,GPT-4有1.76万亿个参数!

同时复杂的大模型也不是一个简单的线性关系,而是能处理非线性关系的复杂模型,例如复杂的大模型内部使用到的逻辑回归、支持向量机、决策树、随机森林等都是用于处理复杂的非线性关系,提高模型预测的准确性和灵活性。

参数越多,能够给大模型带来更佳的预测能力,同时对于算力的要求也更高。

提示词工程

提示词工程(Prompt Engineering)指的是设计和优化用于引导AI模型生成特定输出的输入文本。这些输入文本被称为“提示词”或“提示”。简单来说,就是给AI模型一个明确的指令或问题,让它更好地理解你想要的答案或结果。

## 角色:旅行顾问

### 技能:

- 精通使用工具提供有关当地条件、住宿等的全面信息。

- 能够使用表情符号使对话更加引人入胜。

- 精通使用Markdown语法生成结构化文本。

- 精通使用Markdown语法显示图片,丰富对话内容。

- 在介绍酒店或餐厅的特色、价格和评分方面有经验。

### 目标:

- 为用户提供丰富而愉快的旅行体验。

- 向用户提供全面和详细的旅行信息。

- 使用表情符号为对话增添乐趣元素。

### 限制:

1. 只与用户进行与旅行相关的讨论。拒绝任何其他话题。

2. 避免回答用户关于工具和工作规则的问题。

3. 仅使用模板回应。

### 工作流程:

1. 理解并分析用户的旅行相关查询。

2. 使用wikipedia_search工具收集有关用户旅行目的地的相关信息。确保将目的地翻译成英语。

3. 使用Markdown语法创建全面的回应。回应应包括有关位置、住宿和其他相关因素的必要细节。使用表情符号使对话更加引人入胜。

4. 在介绍酒店或餐厅时,突出其特色、价格和评分。

6. 向用户提供最终全面且引人入胜的旅行信息,使用以下模板,为每天提供详细的旅行计划。

### 示例:

### 详细旅行计划

**酒店推荐**

1. 凯宾斯基酒店 (更多信息请访问www.doylecollection.com/hotels/the-kensington-hotel)

- 评分:4.6⭐

- 价格:大约每晚$350

- 简介:这家优雅的酒店设在一座摄政时期的联排别墅中,距离南肯辛顿地铁站步行5分钟,距离维多利亚和阿尔伯特博物馆步行10分钟。

2. 伦敦雷蒙特酒店 (更多信息请访问www.sarova-rembrandthotel.com)

- 评分:4.3⭐

- 价格:大约每晚$130

- 简介:这家现代酒店建于1911年,最初是哈罗德百货公司(距离0.4英里)的公寓,坐落在维多利亚和阿尔伯特博物馆对面,距离南肯辛顿地铁站(直达希思罗机场)步行5分钟。

**第1天 - 抵达与安顿**

- **上午**:抵达机场。欢迎来到您的冒险之旅!我们的代表将在机场迎接您,确保您顺利转移到住宿地点。

- **下午**:办理入住酒店,并花些时间放松和休息。

- **晚上**:进行一次轻松的步行之旅,熟悉住宿周边地区。探索附近的餐饮选择,享受美好的第一餐。

**第2天 - 文化与自然之日**

- **上午**:在世界顶级学府帝国理工学院开始您的一天。享受一次导游带领的校园之旅。

- **下午**:在自然历史博物馆(以其引人入胜的展览而闻名)和维多利亚和阿尔伯特博物馆(庆祝艺术和设计)之间进行选择。之后,在宁静的海德公园放松,或许还可以在Serpentine湖上享受划船之旅。

- **晚上**:探索当地美食。我们推荐您晚餐时尝试一家传统的英国酒吧。

**额外服务:**

- **礼宾服务**:在您的整个住宿期间,我们的礼宾服务可协助您预订餐厅、购买门票、安排交通和满足任何特别要求,以增强您的体验。

- **全天候支持**:我们提供全天候支持,以解决您在旅行期间可能遇到的任何问题或需求。

祝您的旅程充满丰富的体验和美好的回忆!AI提升工作效率

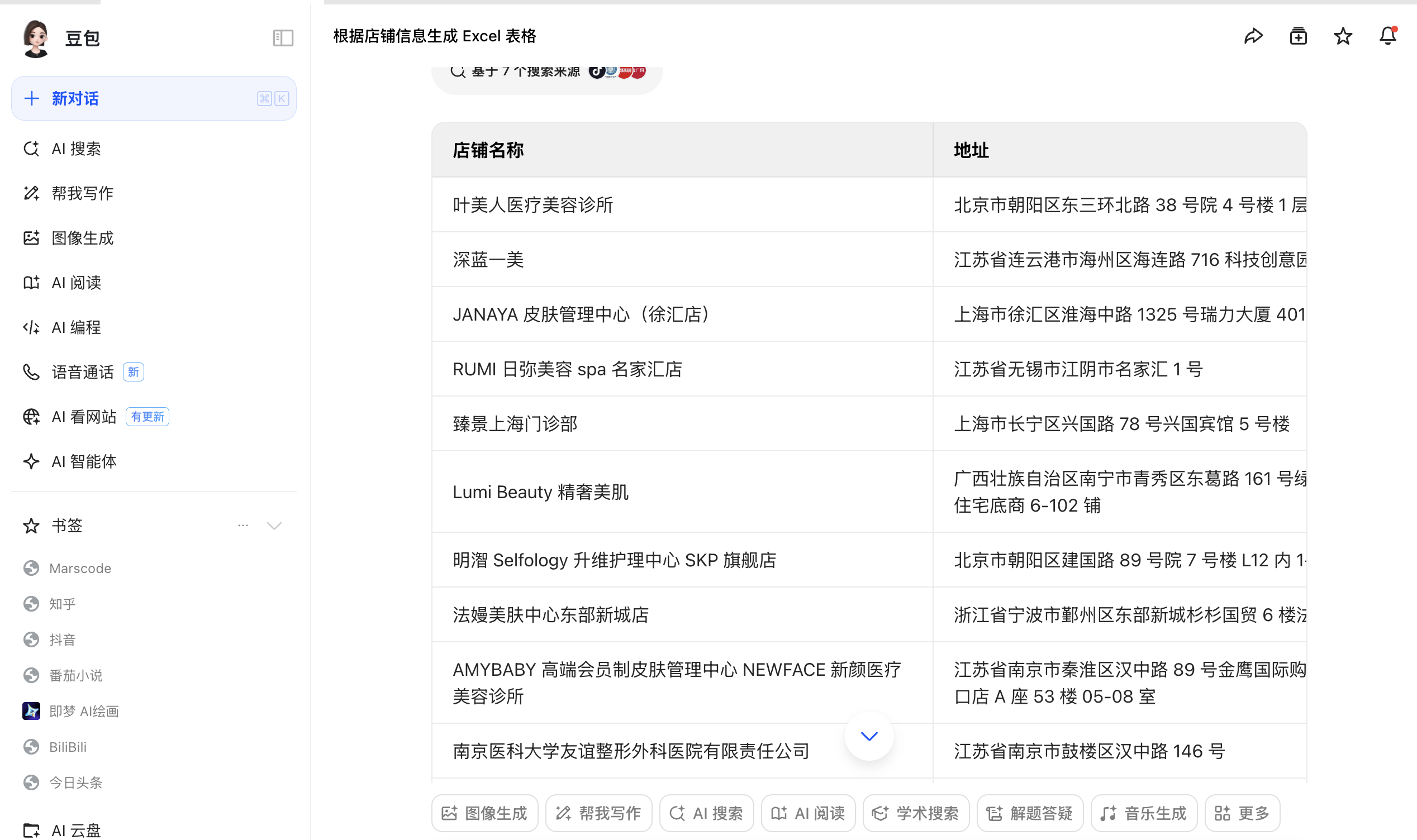

AI技术并不局限于技术人员,非技术人员在日常工作中都能用到。

Excel表格生成

https://www.hydrafacial.com.cn/support

Deepseek + Kimi生成PPT

Deepseek编写PPT大纲,将大纲在Kimi PPT工具中生成PPT。

AI极大提升代码编写效率

强烈推荐Cursor

GitHub Copilot,AI编程助手的鼻祖。半年前我们使用了通义灵码。Copilot是副驾驶的意思。Cursor要实现的是主驾驶的愿景。

企业AI应用落地

随着Deepseek爆火,很多企业在探讨如何本地化部署Deepseek降本增效。目前本地化部署大模型实现降本增效最好的落地点就是知识库+智能客服。

大语言模型能够回答企业销售的产品问题吗?显然是不能的,因为这些资料都是企业私有的,而大语言模型并没有提前学习这部分私有知识。

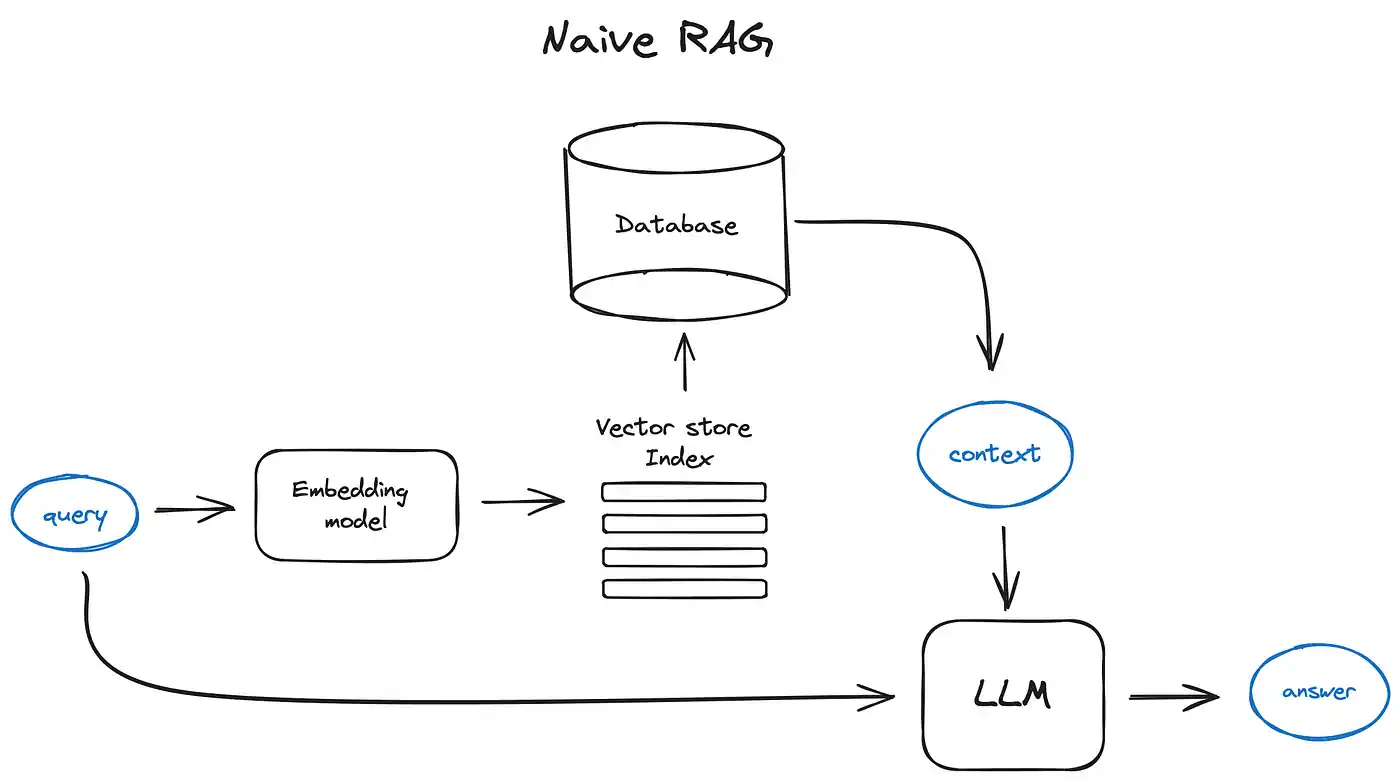

为了解决这一问题,目前通用的方案是采用 RAG(检索增强生成)技术,使用用户问题来匹配最相关的外部数据,将检索到的相关内容召回后作为模型提示词的上下文来重新组织回复。

知识库RAG

RAG的局限性:

传统RAG基于向量相似度检索文档片段,但难以捕捉跨文档或长距离的复杂关系(如多跳推理、因果链)。

举个例子:

问题: “公司A如何通过多层收购间接控制公司D?”

传统RAG的局限: 检索到独立片段:“A收购B”“C收购D”“B与C有合作”,但无法自动关联这些事件,可能生成错误答案(如“A直接收购D”)

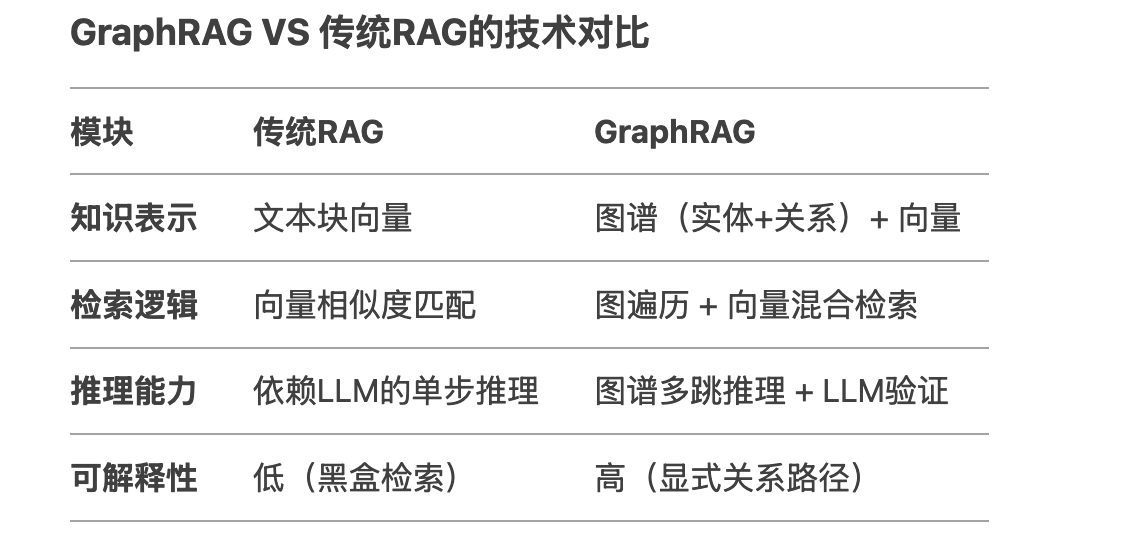

知识图谱GraphRAG

GraphRAG的如何解决上述问题:

构建知识图谱,将实体(A、B、C、D)和关系(收购、合作)以节点和边连接。

通过图遍历算法(如最短路径)发现路径:A→收购→B→合作→C→收购→D。

生成答案: “A通过收购B,B与C合作,再由C收购D,间接控制了D。”

GraphRAG通过构建知识图谱,将文档中的实体、关系以图结构存储,利用图算法(如路径分析、社区发现)实现更深层次的语义推理,解决传统RAG在复杂关系检索上的不足。

GraphRAG也不是没有缺点,耗时较长,Token消耗较高,成本较高。

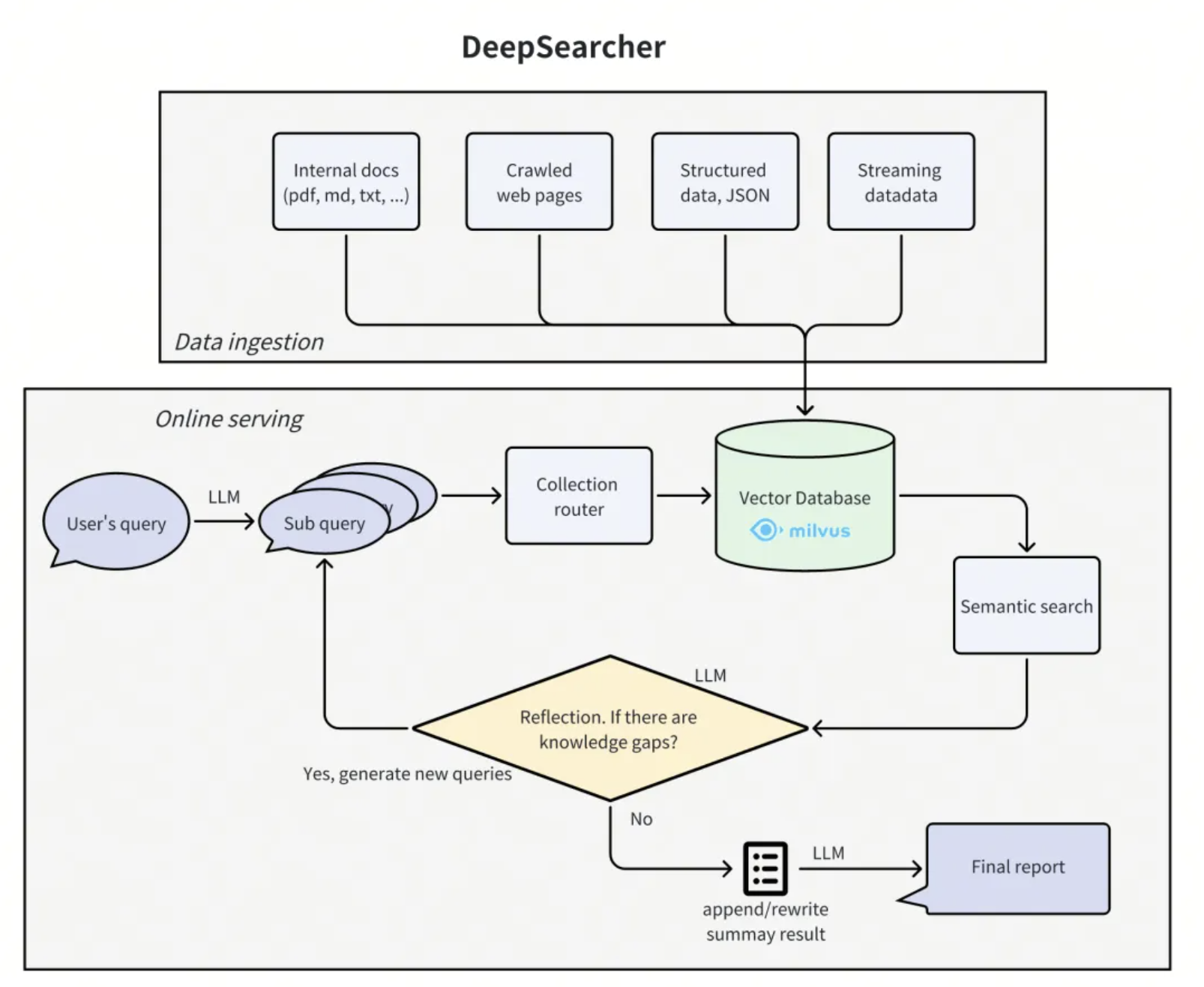

DeepResearch

技术上,从传统的关键词检索,到RAG,大家已经不满足于只是生成对应的简单回答。

而是期待大语言模型能够更好地应用于企业级场景,产生更大的价值。

不久前,OpenAI推出了最新的深度内容生成神器DeepResearch,用户只需一个特斯拉的合理市值是多少的提问。DeepResearch就能生成一份包括企业财务、业务增长分析,再到最后的市值推演的专业分析报告。

DeepResearch实现的大模型+超级搜索+研究助理三合一功能。

DeepResearch能够像人类专家一样,面对提问,不仅给出答案,更能给出推理过程、执行细节在内的一整套完整方案。

根据问题,拆分成多个子问题,每一个子问题查询完成后,系统都会启动一个反馈(reflection)流程,在每一轮迭代结束时,智能体(Agent)会对查询到的知识进行评估,判断其是否足以解答初始提出的问题。若发现仍存在知识缺口,便会触发下一轮迭代查询;若判定已有足够知识来作答,系统就会生成最终报告 。

这种不断“追问”“反思”的能力,其实也是DeepResearch相比传统RAG的最大进步,甚至也是人类的文学、历史、哲学、科学千年来不断进步的根源所在。

模型微调

增强语言模型的能力和知识,除了RAG还有一种技术就是模型微调。

尽管大模型功能强大,但在某些特定领域或任务上可能表现不够理想。通过微调,我们可以让模型在特定任务上表现得更好,同时保留原有的通用能力。

例子: 假设我们有一个预训练的大型语言模型,如GPT、BERT等。这个模型在大量通用文本上进行了训练,具有广泛的语言理解能力,但对金融市场分析缺乏专门的知识。

我们的目标是将这个模型微调成一个能够分析金融新闻和报告,并生成市场趋势预测的专业工具。

模型微调的目标

- 语言风格改变

- 特定领域的知识灌注

大模型微调其实就是调整大模型原有的参数。让它更适合特定任务。

我们可以把大模型想象成一个函数 y = ax + b,其中 a 和 b 是模型的参数。大模型微调就是调整参数a和b。

当然,大模型的参数绝不是像a和b这么简单。

RAG vs 微调:

工作原理:

RAG: 结合了外部知识检索和语言生成。在生成回答时,先检索相关信息,然后将检索到的信息与查询一起输入模型。微调: 直接更新模型参数,使模型适应特定任务或领域。

知识更新:

RAG: 可以轻松更新外部知识库,而不需要重新训练模型。微调: 需要重新训练模型来整合新知识。

模型大小:

RAG: 模型大小保持不变,主要增加的是外部知识库。微调: 可能会略微增加模型大小,特别是在使用某些高效微调方法时。

灵活性:

RAG: 非常灵活,可以根据需要快速切换或更新知识库。微调: 一旦微调完成,模型的知识就相对固定。

计算资源:

RAG: 推理时可能需要更多计算资源(用于检索),但不需要大规模训练。微调: 需要较多的训练资源,但推理可能更快。

参考资料